Recurrent Neural Network

本文以下RNN特指循环神经网络

- 深度神经网络极大的提高了浅层网络的模型拟合数据的能力

- CNN的出现引入了“感受野”的同时共享参数的机制大大减少DNN的网络参数

- 而RNN的出现则是用“记忆单元”可以使得有时序的数据随着时间改变记忆,这个记忆贯穿整个时间流,从而有了时序处理的能力

Recurrent Neural Network

本文以下RNN特指循环神经网络

Deep Neural Networks

https://zh.wikipedia.org/wiki/人工神经网络

eXtreme Gradient Boosting

XGBoost是GBDT的一种实现的代码库,同样也是集成方法的一种

相对原始GBDT主要有以下改进

multi-Grained Cascade Forest

深度级联森林:决策树模型具有可解释性强的优点,多个决策树构成随机森林,多层多个森林构成深度森林

gcForest是西瓜书作者周志华博士和冯霁博士提出的一基于随机森林的深度森林的方法,尝试用深度森林的方法解决深度神经网络中存在的问题:

论文中实验了在小数据集上gcForest,取得了不错的效果

论文地址:https://arxiv.org/pdf/1702.08835.pdf

部分翻译:http://it.sohu.com/20170302/n482153688.shtml

Forward Stagewise Algorithm

SVR,Support Vector Regression,支持向量回归

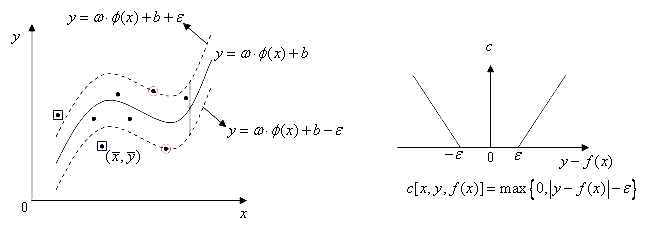

有样本集 \(D=\{(\boldsymbol{x_1},y_1),(\boldsymbol{x_2},y_2),\ldots,(\boldsymbol{x_m},y_m)\}\)。其中, \(\boldsymbol{x_i}\)是一个样本,列向量;\(y_i\)为回归目标,\(y_i \in \mathbb{R}\)。 找到一个回归模型\(f(x) = \boldsymbol{w}^T\boldsymbol{x} + b\),使得\(f(\boldsymbol{x})\)与\(y\)在损失为\(\epsilon\)不敏感损失下尽可能接近,其中回归线由落在\(\boldsymbol{w} \cdot \boldsymbol{x} + b - \epsilon = 0\)与\(\boldsymbol{w} \cdot \boldsymbol{x} + b + \epsilon = 0\)区域内的点参与构建